지구과학 전문가

[인공지능] 오픈AI, ‘보고 듣고 말하는’ 새로운 AI 모델 ‘GPT-4o’ 출시 본문

반응형

오픈AI, ‘보고 듣고 말하는’ 새로운 AI 모델 ‘GPT-4o’ 출시

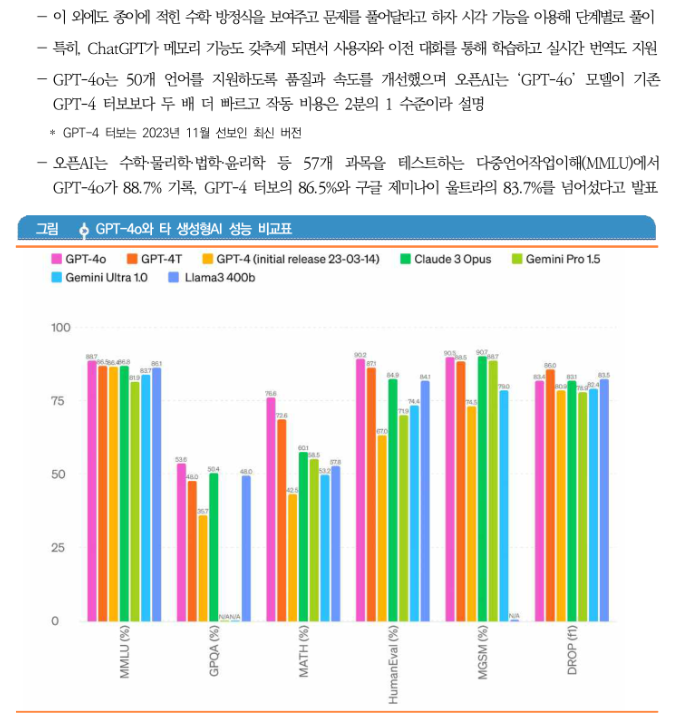

챗GPT 선도자 오픈AI는 텍스트는 물론, 청각과 시각으로도 추론하고 이를 말할 수 있는 새로운 AI 모델 ‘GPT-4o’를 발표하며 다양한 시연 영상 공개(5.13)

* GPT-4o의 ‘o’는 하나의 통합된 AI 모델을 의미하는 ‘옴니모델(Omni model)’ 의미

‘GPT-4o’는 음성 인식, 스피치-투-텍스트(Speech to text), 이미지 인식 기능 등이 통합돼 대화형 인터페이스 형태로 자연스러운 실시간 상호작용이 가능한 멀티모달(Multimodal, 다중 모드) 모델

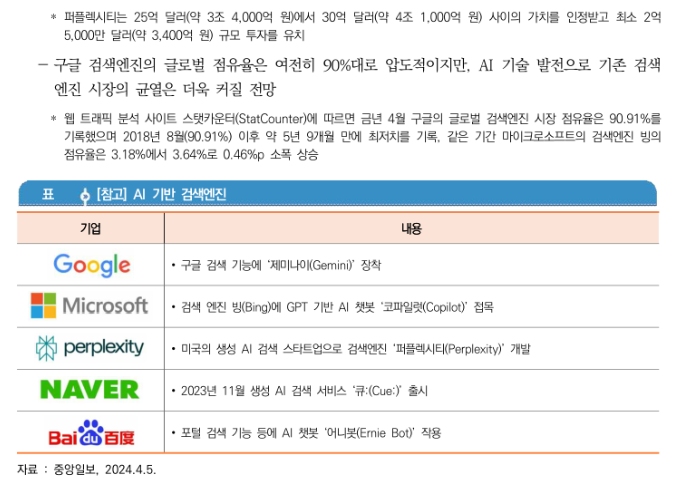

아울러, 오픈AI는 구글·MS 등 경쟁사 검색엔진에 대응해 AI 기반 실시간 검색 서비스 출시도 임박한 것으로 알려져 이목 집중

ㅇ 구글 I/O 2024(연례개발자회의), 제미나이 앞세워 AI 생태계 확장

구글 I/O2024에서 키노트에 등장한 순다르 피차이는 무려 121번이나 AI를 언급하며 구글 全생태계에 AI를 접목해 25년 검색 역사를 AI로 탈바꿈하는 포부 구체화(美 캘리포니아 쇼어라인 앰피시어터(Shoreline Amphitheatre) 개최, 5.14, 현지 시간)

AI모델 개발이나 서비스 구축에 항상 한발 앞서가는 오픈AI에 대항하기 위해 구글이 기존에 구축해 놓은 거대 생태계를 활용해 ‘AI중심 회사’로 도약 목표

AI 기반 검색엔진, 제미나이 업데이트(1.5 프로·플래시), 프로젝트 아스트라, TPU의 6세대 모델 ‘트릴리움’ 등이 주요 내용

728x90

반응형

'인공지능' 카테고리의 다른 글

| [동물 분석 AI모델 SUBTLE] 동물 행동 읽어내는 인공지능(AI) 프레임워크 개발 (101) | 2024.05.24 |

|---|---|

| [스마트시] 스마트도시 솔루션으로 교통편의를 증진하고, 지역경제 활성화 . 스마트시티 솔루션 확산사업 선정 (103) | 2024.05.24 |

| [인공지능] 지자체의 생성형 AI 활용현황과 가이드라인 (105) | 2024.05.20 |

| [프로그램 언어] MATLAB에서 Python 함께 사용하기 (75) | 2024.04.17 |

| [차세대 지능형교통체계] 어린이 등·하굣길 안전지킴이, C-ITS 차세대 지능형교통체계 서비스 (58) | 2024.04.15 |